本記事はDatabricks社の公式発表「Mosaic AI Announcements at Data + AI Summit 2025」を元に作成しています。

はじめに

Data + AI Summit 2025でDatabricksが発表した最新のMosaic AI技術について、読みやすくまとめました。エンタープライズAI活用を大きく前進させる注目の新機能をご覧ください。

免責事項・著作権表示

- 本記事は非公式の翻訳・要約であり、正確かつ最新の情報についてはDatabricks社の公式ドキュメントをご参照ください

- Databricks、Mosaic AI、MLflow、Unity Catalogなどは、Databricks, Inc.の商標または登録商標です

- 本記事は非営利目的の技術情報共有として作成されています

主要な新機能ハイライト

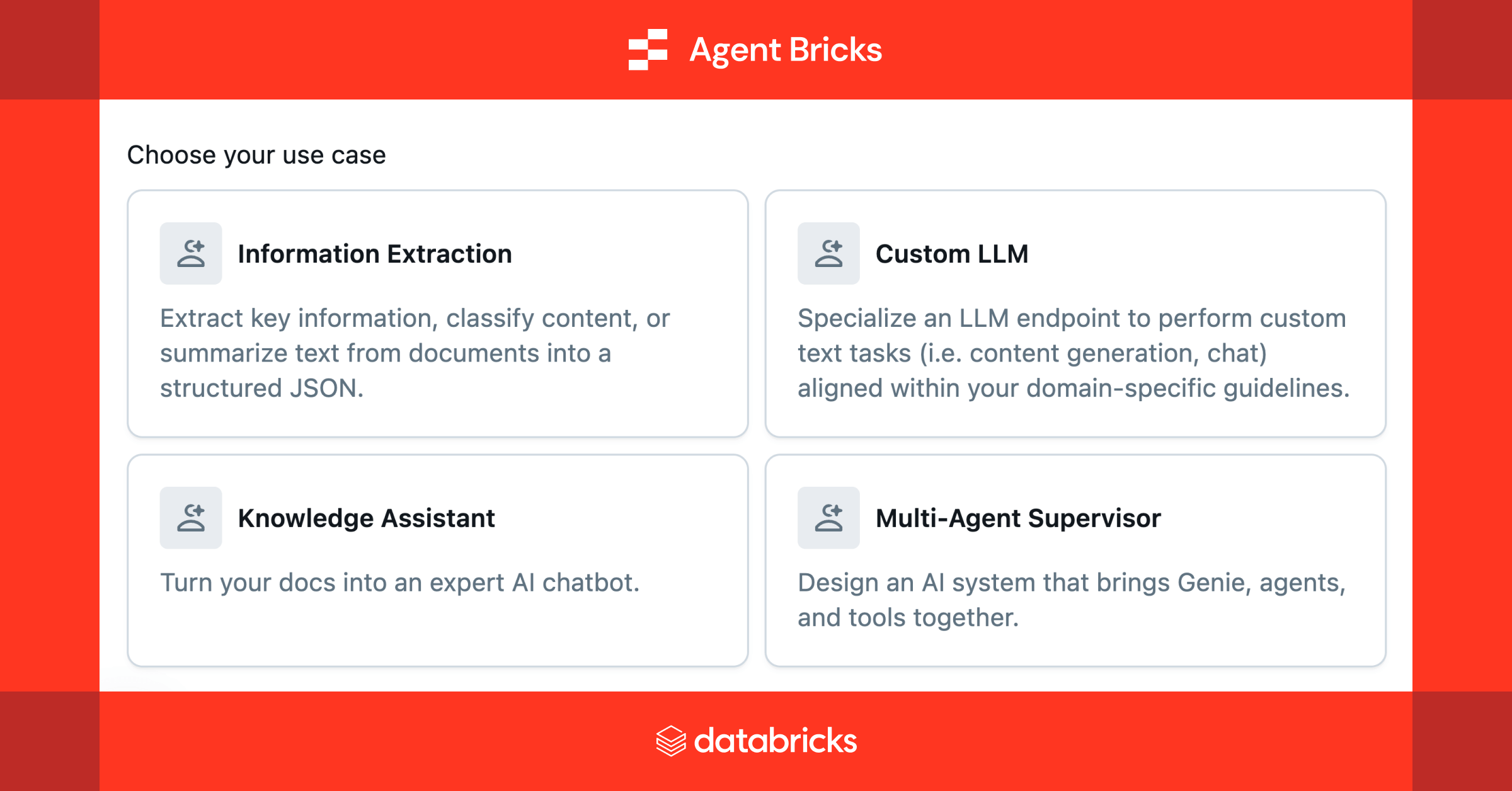

Agent Bricks(ベータ版)

簡単にAIエージェントを構築できる画期的な新機能

Agent Bricksは、データに基づいて自動的に最適化された高品質なエージェントを構築する新しい方法です。エージェントのタスクの概要を記述し、エンタープライズデータを接続するだけで、残りはAgent Bricksが処理します。

- タスクを記述するだけで、高品質なエージェントを自動生成

- エンタープライズデータに接続するだけでカスタマイズ可能

- 以下のユースケースに最適化:

- 構造化情報の抽出

- ナレッジアシスタンスの構築

- カスタムテキスト変換

- マルチエージェントシステムの開発

詳細については以下記事をご覧ください

MLflow 3.0

GenAI時代に完全対応した進化版MLflow

MLflow 3.0は、Generative AI向けにゼロから再設計されたバージョンです。モニタリング、評価、ライフサイクル管理の最新機能が搭載され、Databricksの外部で動作するエージェントも含め、包括的な管理が可能になりました。

- クロスプラットフォーム可観測性:

- Databricks外で動作するエージェントもリアルタイム監視

- AWS、GCP、オンプレミスなど環境を問わず対応

- プロンプトレジストリ機能:

- LLMプロンプトの登録・バージョニング・テスト・展開が可能

- プロンプトエンジニアリングのライフサイクル管理を効率化

SQLにおけるAI Functions強化

大幅なパフォーマンス向上とマルチモーダル対応

AI Functions により、ユーザーはSQL内から生成AIのパワーに容易にアクセスできるようになります。今年は、AI Functions のパフォーマンスが劇的に向上し、マルチモーダル機能が拡張されました。

| 強化ポイント | 詳細 |

|---|---|

| パフォーマンス | 競合製品より最大3倍高速、4倍コスト効率 |

| マルチモーダル | テキストだけでなく画像も処理可能に |

| 新機能 | ai_parse_documentで複雑文書から情報抽出 |

ストレージ最適化Vector Search(パブリックプレビュー)

RAGシステム構築の経済性を飛躍的に向上

Mosaic AI Vector Searchは、多くのRAGシステムや検索エンジンのバックボーンとなる重要なコンポーネントです。今回の刷新により、コンピューティングとストレージを分離する設計が採用され、大幅なコスト削減と高いスケーラビリティを実現しました。

- コンピューティングとストレージを分離する新アーキテクチャ

- コスト削減効果: 従来比で1/7のコストを実現

- 数十億のベクトルにも対応する優れたスケーラビリティ

詳細については以下記事をご覧ください

サーバーレスGPUコンピューティング(ベータ版)

GPU管理の複雑さから解放されたAI開発環境

DatabricksのサーバーレスプラットフォームにGPUサポートが追加され、AIワークロードの実行がさらに容易になりました。インフラ管理の複雑さを排除し、必要な時に必要なだけGPUリソースを利用できる柔軟性を提供します。

- Databricksプラットフォームに完全統合

- 利用可能なGPU:

- A10G: 現在ベータ版提供中

- H100: 近日公開予定

- Unity Catalogによる完全なガバナンス

- サーバーレスノートブックとジョブをGPU上で実行可能

ハイスケールなモデルサービング

本番環境に対応する高性能インフラ

今日のエンタープライズAIアプリケーションは、より高いスループットと低いレイテンシーを必要としています。Databricksの強化されたモデルサービングインフラは、この需要に応えるため大幅に性能向上されました。

- スループット: 毎秒250,000クエリ(QPS)をサポート

- 独自推論エンジン:

- Meta Llamaなどのオープンソースモデルを高速化

- 一般的な設定のvLLM-v1より最大1.5倍高速

- リアルタイムのオンラインML向けに最適化

MCPサポート

AnthropicのModel Context Protocolとの統合

AnthropicのModel Context Protocol(MCP)は、大規模言語モデルにツールとナレッジを提供するための標準プロトコルです。Databricksはこのプロトコルをプラットフォームに直接統合し、よりパワフルなAIエージェントの開発を容易にしました。

- MCPサーバー:

- Databricks Appsでホスト可能

- 追加インフラ管理不要でMCP準拠サービスを展開

- Playgroundサポート:

- MCP対応モデルをその場でテスト

- 様々なモデル構成や機能を簡単に試験

- 主な接続先:

- UC Functions

- Genie

- Vector Search

詳細についてはドキュメントをご覧ください

AI Gateway(一般提供開始)

AIサービス管理のための統一プラットフォーム

Mosaic AI Gatewayが正式に一般提供されました。

この機能により、組織内で利用するあらゆるAIサービスに対して統一されたアクセスポイントを提供し、AI活用のガバナンスと管理を効率的に実現します。

- 主な機能:

- ガバナンスの一元化:すべてのAIサービスに対するポリシーやアクセス管理を集中管理

- 使用状況の可視化と制御:ログの記録と利用状況の追跡により、透明性を確保

- プロバイダー間の自動フェイルオーバー:複数のAIプロバイダーをまたいでのサービス継続性を確保

- PII保護と安全性のガードレール:個人情報や倫理的配慮に対応した制御機能を提供

- メリット:

- レート制限ポリシーの簡単な設定:サービスの乱用防止やリソース最適化が容易

- 使用状況の透明なトラッキング:ガバナンスやコンプライアンスのための記録管理が強化

- セキュリティガードレールの一元適用:安全基準を全サービスにわたって一貫して適用可能

まとめ

Databricksの今回の発表は、エンタープライズAIのアクセシビリティ、パフォーマンス、コスト効率を大きく向上させる重要なものです。Agent Bricksによるエージェント構築の簡易化、Vector Searchのコスト削減、そしてSQLでのAI機能強化は、ビジネスにすぐに貢献する実用的な価値をもたらします。

これらの最新技術はすでに一部で試用可能です。

詳細はDatabricks公式サイトをご確認いただくか弊社までお問い合わせください。

ナレッジコミュニケーションでは、Databricks Data + AI Summit 2025 開催にあわせてセッションレポートや、イベント情報を公開しております!

ぜひナレッジコミュニケーションDAIS2025 特設サイトからチェックしてみてください!